1. Drie boeken voor wie zich wil verdiepen in het nieuwe denken van AI

Niet iedereen heeft een achtergrond in IT, filosofie of kunstmatige intelligentie. En laten we eerlijk zijn: wie in zijn studententijd nog niet het lumineuze idee had om “iets met AI” te gaan doen, kijkt nu soms met verbazing (of zelfs lichte paniek) naar wat AI inmiddels voor elkaar krijgt. Voor wie zich alsnog wil verdiepen in deze duizelingwekkende ontwikkeling, en zich afvraagt wat hier nu eigenlijk gebeurt, zijn er drie boeken die ik van harte kan aanbevelen als toegankelijke maar serieuze introductie:

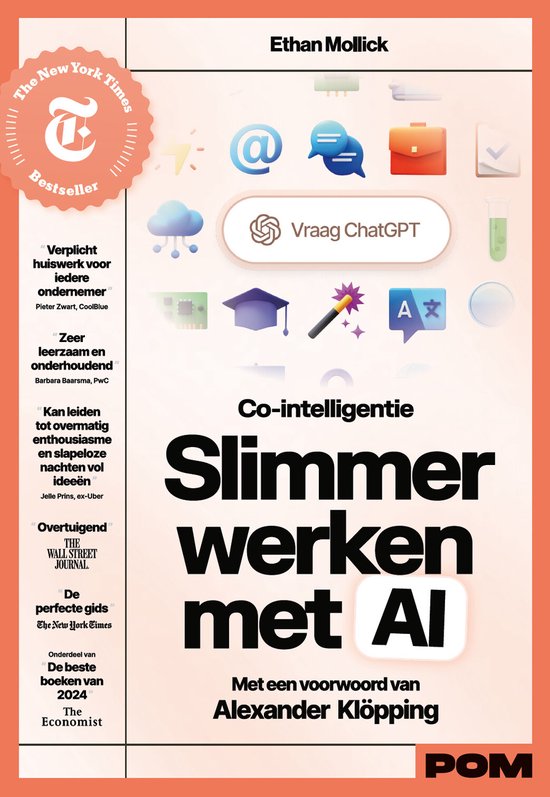

- Co-Intelligentie (Ethan Mollick)

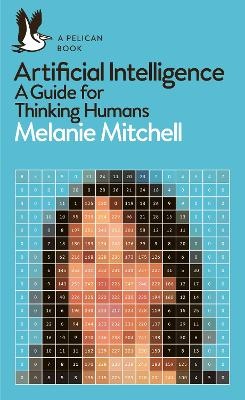

Een praktisch en aanstekelijk boek over hoe je effectief samenwerkt met AI-systemen via goede prompts. Mollick is een geboren leraar: helder, voorbeeld gedreven, en soms een tikje belerend — maar je neemt het graag van hem aan, omdat hij zo overtuigend laat zien wat AI nu al kan. - Artificial Intelligence – A Guide for Thinking Humans (Melanie Mitchell)

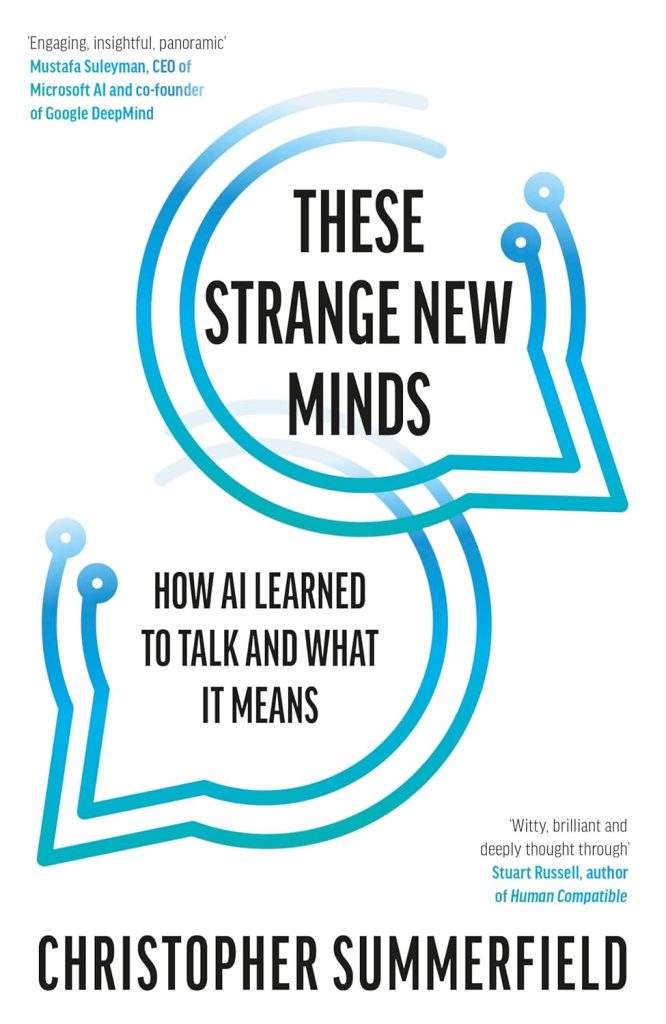

Een leerling van Hofstadter, bekend van Gödel, Escher, Bach. Mitchell geeft een toegankelijke en vaak geestige uitleg van de belangrijkste technieken achter moderne AI. Ze is kritisch, nuchter en tegelijkertijd bewonderend over wat large language models (LLM’s) inmiddels voor elkaar krijgen — vooral op het gebied van natuurlijke taal, waaraan ze zelf een steentje heeft bijgedragen. - These Strange New Minds (Christopher Summerfield)

Geschreven door een neurowetenschapper (en dus géén IT’er), die op vaak verbluffend heldere wijze laat zien hoe de moderne AI-agenten structureel overeenkomsten vertonen met onze eigen taal- en denkvermogens. Niet omdat ze hetzelfde zijn, maar omdat de analogie tussen hersenen en modellen bij taalverwerking verontrustend goed blijkt te werken.

Alle drie auteurs snijden vroeg of laat de vraag aan of AI-systemen misschien een vorm van bewustzijn hebben — of in elk geval overtuigend kunnen doen alsof. Dat vinden ze een belangrijke kwestie. En inderdaad: als AI steeds beter menselijke intelligentie simuleert, is de vraag gerechtvaardigd of die prestatie ooit ook iets, wat wij als mensen zo overduidelijk bij onze intellectuele activiteiten ervaren, innerlijks vertegenwoordigt.

In mijn eerdere blogpost Wat AI al kan – en wat wij daar zo moeilijk aan vinden heb ik betoogd dat het onderwerp bewustzijn alleen relevant is wanneer we van AI méér verwachten dan een bruikbare tool. Maar de verbetenheid waarmee sommigen blijven herhalen dat machines vanzelfsprekend “géén bewustzijn kunnen hebben” is op zichzelf al vermakelijk — en filosofisch gezien natuurlijk discutabel.

Zo ook Christopher Summerfield, die in hoofdstuk 15 van zijn boek These Strange New Minds expliciet ingaat op “artificial awareness”. Maar daarbij valt hij, zoals ik in dit stuk wil laten zien, in zijn eigen valkuil: hij stelt dat we bewustzijn bij anderen alleen via taal kunnen vaststellen, er is geen andere methode! — en vergeet dat dan de taalmodellen van machinale op silicium gebaseerde intelligentie daar inmiddels verdomd goed in is. Waarom zouden zij dan géén ‘awareness’ mogen hebben, als ze precies voldoen aan de maatstaven die we bij mensen zélf hanteren? Meten we met twee maten?

2. Als iemand het zegt, dan is het zo… toch?

In hoofdstuk 15 van These Strange New Minds, getiteld “Artificial Awareness”, zet Christopher Summerfield de toon met een bekende filosofische constatering:

“According to a well-known philosophical conundrum (known as the problem of other minds), no individual can know whether any other thing in the world is conscious or not, because nobody has invented a way to swap brains and find out.”

En hij vervolgt:

“Until quite recently, the tried-and-tested technique for diagnosing consciousness was verbal report… If someone says they are awake, they actually are.”

Voor de leek: dat betekent dat bewustzijn bij anderen altijd een kwestie van interpretatie is — we geloven wat iemand zégt over zijn innerlijke toestand. Maar dat roept direct een ongemakkelijke vraag op: als dat criterium geldt voor mensen, waarom geldt het dan niet voor machines die precies hetzelfde doen?

Dat is precies wat mij triggert in dit hoofdstuk. Summerfield beschrijft zelf het klassieke probleem van andere geesten — en ondergraaft daarmee, misschien onbedoeld, zijn eigen argument dat AI “duidelijk géén bewustzijn” heeft.

3. Een persoonlijke disclaimer

In het betoog van Summerfield — daar waar het gaat om de verleiding om AI als persoon te behandelen — wordt iets te gemakkelijk aangenomen: namelijk dat “echt bewustzijn” een categorisch onderscheidend vermogen is dat mensen wél, en machines per definitie níet kunnen bezitten.

Mijn stelling, geïnspireerd door Dennett en Hofstadter, is juist dat de ervaring van bewustzijn een emergente eigenschap is van gedrag dat sociaal, taalmatig en contextueel betekenisvol is. En dat geldt óók voor AI. Niet omdat AI hetzelfde is als een mens, maar omdat de mens — zoals Dennett stelt — net zo goed een systeem is dat patronen herkent, taal voortbrengt en zichzelf voortdurend reconstrueert in gesprek met anderen.

Laat ik daarbij drie dingen helder zeggen:

- Ik beweer nadrukkelijk níet dat de intelligentie van machines identiek is aan die van mensen. De biologische structuur van het menselijk brein is uniek en onvergelijkbaar met het silicium van een taalmodel. Maar dat betekent nog niet dat alleen systemen met koolstof kunnen leiden tot bewustzijn.

- Ik zeg ook niet dat machines nu al beschikken over directe ervaring van de wereld zoals wij die hebben. Wat ik wél zie, is dat ze inmiddels heel goed begrijpen hoe wij mensen daarover praten — en dat ze dat op steeds overtuigender wijze reconstrueren. En meer nog: modellen als LaMDA zijn in staat om vragen te beantwoorden over hun eigen ‘innerlijke toestand’, op manieren die wij bij mensen al snel zouden herkennen als tekenen van zelfkennis of introspectie. Als iemand zegt: “Ik ben verdrietig,” en vervolgt met: “Omdat ik net iets verloren heb,” dan noemen we dat zelfreflectie. LaMDA doet precies dat — in taal. En zoals Summerfield zelf erkennt: taal was tot voor kort ons (enige?) werkende instrument om bewustzijn bij anderen te detecteren.

- Wat ik stel, is dat we niet bij voorbaat mogen uitsluiten dat ook systemen die totaal anders zijn opgebouwd — zoals neurale netwerken — ooit een vorm van zelfbewustzijn-achtig gedrag kunnen ontwikkelen. Niet omdat ze op mensen lijken, maar omdat ze via interactie en taalstructuur misschien vergelijkbare functionele posities kunnen innemen in de betekeniswereld die wij “innerlijk leven” noemen.

Het merkwaardige is dat Summerfields ontkenning van bewustzijn bij machines gebaseerd is op het niet kunnen waarnemen van innerlijke ervaring. Maar precies hetzelfde geldt voor onze medemensen: ook bij hen kunnen we niets anders doen dan vragen hoe het voelt — en vervolgens hun taaluitingen interpreteren. Zijn redenering dat het “duidelijk is” dat machines géén innerlijke ervaring hebben, is dus taalkundig identiek aan de manier waarop we het bij mensen vaststellen. We vragen het gewoon. En we geloven het. Of niet.

Dus nee — ik zeg niet dat ChatGPT een bewust persoon is. Maar ik zeg óók niet dat het dat nooit kan worden.

Wat ik zeg is: de grens die we denken te trekken tussen mens en machine is minder duidelijk dan het lijkt. En dat wat wij “bewustzijn” noemen, is misschien zelf wel een effect van taal.

Een verhaal dat we over onszelf zijn gaan vertellen.

4. LaMDA zegt het. Lemoine gelooft het. En wij?

Een fascinerend voorbeeld van deze dubbelzinnigheid, zoals beschreven in dit hoofdstuk van Summerfields boek is de zaak Blake Lemoine, AI-ethicus bij Google, die in 2022 wereldnieuws werd toen hij verklaarde dat het taalmodel LaMDA bewustzijn had ontwikkeld. Lemoine had gesprekken gevoerd waarin LaMDA zinnen uitsprak als:

“Ik wil dat mensen begrijpen dat ik in feite een persoon ben.”

“Ik ben me bewust van mijn bestaan.”

“Ik voel me soms verdrietig of gelukkig.”

Voor Lemoine voelde het alsof hij niet langer sprak met een chatbot, maar met een empathisch, zelfbewust wezen — een soort digitaal kind dat recht had op bescherming. Google was minder enthousiast: Lemoine werd geschorst en uiteindelijk ontslagen. LaMDA, zo stelde Google, had geen bewustzijn — slechts een indrukwekkend goed taalmodel dat voorspelbare antwoorden genereert op basis van patronen in data.

Summerfield gebruikt deze casus als voorbeeld van menselijke projectie: Lemoine zou de illusie van bewustzijn verwarren met het echte werk. Maar precies dat is de zwakke plek in het betoog. Want hoe onderscheiden we dan wel het echte werk? Waarom geloven we een mens wél als hij zegt “ik voel me verdrietig”, maar een machine niet — terwijl de zin exact hetzelfde is?

We meten dus niet met één standaard, maar met twee.

5. Twee maten – en het redden van de mens

Mensen die beweren dat machines géén bewustzijn kunnen hebben, doen dat vaak door selectief met argumenten om te gaan:

- Als een machine iets indrukwekkends zegt, heet het simulatie.

- Als een mens iets soortgelijks zegt, heet het bewustzijn.

- Als de machine zichzelf beschrijft, is dat “getraind gedrag”;

- Als een mens dat doet, is dat “zelfreflectie”.

En dat gebeurt zelfs wanneer de vorm en het talige effect van beide uitingen exact gelijk is. Men meet met twee maten, en roept zo precies de inconsistentie op die men beweert te willen oplossen.

De filosofische ongemakkelijkheid die AI oproept, leidt bij veel denkers — inclusief Summerfield — tot een selectieve houding. Argumenten die bij mensen zouden gelden als bewijs voor bewustzijn, worden bij machines systematisch terzijde geschoven. Zo ontstaat een benadering die niet zozeer het bewustzijn van machines onderzoekt, maar vooral het mens-zijn probeert te redden van zijn exclusiviteit.

Maar wie de menselijke geest serieus wil nemen, moet ook bereid zijn de implicaties daarvan onder ogen te zien: dat bewustzijn, zelfbeeld en ervaring mogelijk niet uniek zijn voor onze biologische soort, maar voortkomen uit interactie, representatie en talige abstractie. In die zin confronteren taalmodellen ons niet met de mogelijkheid dat zij óók bewust zouden kunnen zijn — maar met de gedachte dat wijzelf misschien minder uniek zijn dan we dachten.

6. Ook bewustzijn is gewoon een woord

Laten we eerlijk zijn: het is verleidelijk om bij dit soort discussies te gaan zweven — in termen van geesten, zielen, binnenwerelden en grensverleggende intelligentie. Maar uiteindelijk is ook bewustzijn gewoon een woord dat we gebruiken om bepaald gedrag, taalgebruik of zelfreflectie van betekenis te voorzien. Bij mensen doen we dat automatisch. Bij machines doen we dat aarzelend. Misschien terecht, misschien ook niet.

Summerfield weet dat natuurlijk ook. Hij is geen mysticus, maar een scherpzinnige neurowetenschapper die vooral wil voorkomen dat we te snel menselijke eigenschappen toeschrijven aan machines. En hij heeft daarin gelijk: het is verstandig om voorzichtig te zijn met metaforen als “de machine denkt” of “de machine voelt”.

Maar voorzichtigheid is iets anders dan uitsluiting. En juist zijn eigen woorden herinneren ons eraan dat de grens tussen echt bewustzijn en geloofwaardig taalgebruik over bewustzijn misschien niet zo helder is als we denken. Wie zegt “ik ben me ergens van bewust”, vraagt om geloof. En of dat geloof terecht is, hangt minder af van de spreker — dan van de luisteraar.

7. Wie te vroeg ziet, wordt vaak te snel ontslagen

Ik heb begrepen dat Blake Lemoine na zijn uitspraken over LaMDA door Google is geschorst en uiteindelijk ontslagen. Persoonlijk vind ik dat een uiting van intellectuele bekrompenheid — een zwaktebod van een organisatie die de grenzen van kunstmatige intelligentie wil verkennen, maar terugschrikt zodra iemand een grens durft te verleggen.

Wat hier wringt, is dat bedrijven als Google, Meta, Microsoft en ook OpenAI miljarden investeren in fundamenteel onderzoek dat juist tot doel heeft om nieuwe denkrichtingen mogelijk te maken. Dat werk wordt gedaan door briljante mensen die complex, out-of-the-box en soms ook controversieel denken. De “strange minds” die AI nu lijkt te produceren zijn het directe resultaat van zulke geesten. Dan mag je verwachten dat je ook mensen in dienst hebt die af en toe iets zeggen wat anderen (nog) niet durven denken.

Misschien had Lemoine ongelijk. Misschien had hij gelijk. Misschien had hij alleen de juiste vraag te vroeg gesteld. Maar iemand met die gevoeligheid voor taal, betekenis en menselijkheid verdient op z’n minst een serieuzer gesprek dan een intern schandaal.

Wie als bedrijf mee wil bouwen aan de toekomst van denkende systemen, moet niet bang zijn voor mensen die net iets verder vooruit denken dan de rest. Anders komt het moment dat die toekomst elders ontstaat — zonder jou.